北京时间,凌晨四点,英伟达创始人兼CEO黄仁勋在美国加州圣何塞SAP中心进行主题为“面向开发者的“1#AI Conference for Developers”演讲拉开了此次NVIDIA 2024 GTC AI大会的帷幕。黄仁勋介绍了名为Blackwell的新一代AI图形处理器(GPU)。

作为目前全球市值第三大公司的掌舵人,黄仁勋认为,“通用计算已经失去动力,现在我们需要更大的模型,我们需要更大的 GPU,并需要将这些 GPU 堆叠在一起。”,随着大模型参数量正在呈指数级增长,此前 OpenAI 最大的模型已经有 1.8T 参数,需要吞吐数十亿 token。一块 PetaFLOP 级的GPU,训练这样大的模型也需要 1000 年才能完成。

为了帮助世界构建更大的 AI,英伟达必须首先拿出新的 GPU,这就是英伟达此次发布的 Blackwell 平台。从此以后,在数万亿参数上构建和运行实时生成式 AI 大型语言模型的成本和能耗降低到此前的 25 分之一。

Blackwell 平台继承了 Hopper GPU 架构,将为加速计算树立了新的标准。作为英伟达首个采用 MCM(多芯片封装)设计的 GPU,Blackwell 可在同一个芯片上集成了两个 GPU。

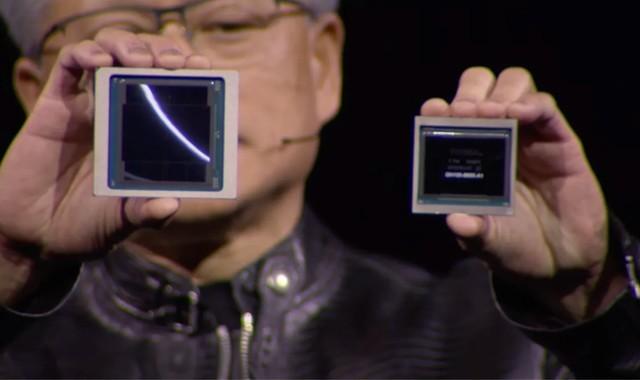

Blackwell(右手)与 Hopper GH100 GPU(左手)的尺寸对比

Blackwell 作为目前世界上最强大的芯片。Blackwell 架构的 GPU 拥有 2080 亿个晶体管,采用定制的、双 reticle 的台积电 4NP(4N 工艺的改进版本)制程工艺,两块小芯片之间的互联速度高达 10TBps,而CUDA 将其视为单块 GPU,可以大幅度提高处理能力。

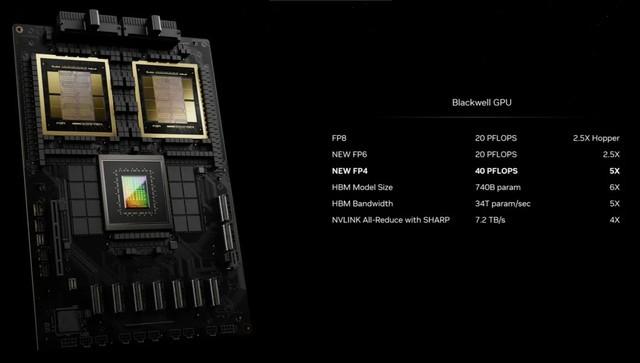

它还带有 192GB 速度为 8Gbps 的 HBM3E 内存,FP4 精度下AI 算力能达到 20 petaflops,而上代的 H100仅为4 petaflops。

采用 Blackwell 架构的 GPU 分为了 B200 和 GB200 产品系列,后者集成了 1 个 Grace CPU 和 2 个 B200 GPU。其中 B200 GPU 通过 2080 亿个晶体管提供高达 20 petaflops 的 FP4 吞吐量。而 GB200 GPU 通过 900GB / 秒的超低功耗芯片到芯片连接,将两个 B200 GPU 连接到 1 个 Grace CPU 上。

GB200 系列产品中包含两个 GPU 和一个 CPU。相较于 H100 Tensor Core GPU,GB200 超级芯片可以为大语言模型(LLM)推理负载提供 30 倍的性能提升,并将成本和能耗降低高达 25 倍。

如今,显卡不再是显卡,而是作为系统整体售卖,毕竟只有通过英伟达自家的组件才能达到最佳效率。“现在我们卖的 GPU 是3000 磅重的 7000 个组件。”

基于 Blackwell 的 AI 算力将以名为 DGX GB200 的完整服务器形态提供给用户,结合了 36 颗 NVIDIA Grace CPU 和 72 块 Blackwell GPU。这些超级芯片通过第五代 NVLink 连接成一台超级计算机。

再往上扩展,Grace Blackwell 架构的 DGX SuperPOD 由 8 个或以上的 DGX GB200 系统构建而成,这些系统通过 NVIDIA Quantum InfiniBand 网络连接,可扩展到数万个 GB200 超级芯片。用户可通过 NVLink 连接 8 个 DGX GB200 系统中的 576 块 Blackwell GPU,从而获得海量共享显存空间,来训练下一代 AI 模型。

再详细对比一下性能的升级,以前使用 Hopper 训练 GPT-MoE-1.8T,8000 块 GPU 要花费 90 天,GB2000只需要 2000 块,能耗也只需要四分之一。

此外,大模型(LLM)的大规模推理始终是一个挑战,并非适合单个 GPU 的任务。在具有 1750 亿个参数的 GPT-3 LLM 基准测试中,GB200 的性能是 H100 的 7 倍,并且训练速度是 H100 的 4 倍。

“DGX 超级计算机是推进 AI 产业变革的工厂。新一代 DGX SuperPOD 集加速计算、网络和软件方面的最新进展于一身,能帮助每一个公司、行业和国家完善并生成自己的 AI,”黄仁勋说道。

第二代 Transformer 引擎和第五代 NVLink让AI算力提升30倍

除了使用新制程,并联两块芯片以外,Blackwell 的关键改进在于引入第二代 Transformer 引擎,它支持了 FP4 和 FP6,使得计算、带宽和模型大小翻了一番。得益于新的微张量(micro-tensor)扩展支持和集成到英伟达 TensorRT-LLM 和 NeMo Megatron 框架中的先进动态范围管理算法,Blackwell 通过 4-bit 浮点 AI 推理能力支持了双倍的算力和模型大小。

当互联大量此类 GPU 时,第二个关键区别开始显现:下一代 NVLink 交换机可让 576 个 GPU 相互通信,具有每秒 1.8 TB 的双向带宽。英伟达表示,此前,仅由 16 个 GPU 组成的集群会在相互通信上花费 60% 的时间,而只有 40% 的时间用于实际计算。现在,英伟达的 NVLink Switch Chip 可以让所有这些芯片互联起来,全速运转没有瓶颈(1.8TB/s,几乎比上代快 10 倍),并帮助构建了 DGX GB200 NVL72。

通过高速互联的机制,DGX GB200 NVL72 可以被认为是一个超级 GPU,FP8 训练吞吐量高达 720 PFLOPS、FP4 推理吞吐量为 1.44 ExaFLOPS,多节点 All-to-All 通信速度为 130TB / 秒,多节点 All-Reduce 通信速度为 260TB / 秒。

在具体架构方面,DGX GB200 NVL72 拥有 18 个 GB200 节点机架,每个节点搭配 2 个 GB200 GPU。此外还有 9 个 NVSwitch 机架,从而为 GB200 NVL 提供了 720 PFLOPS 的 FP8 吞吐量,以及 FP4 精度的 ExaFLOPS。

所以今年画风变了现在 DGX 长这样:拥有 5000 条 NVLink 电缆,长达 2 英里,都是铜电缆,不需要光收发器,节省了 20kW 的计算成本。它的功耗过大,以至于需要用液冷,同时重量高达 3000 磅。

(8613070)